记录一下我的AI之路

本文最后更新于 2025-11-10,墨迹未干时,知识正鲜活。随着时间推移,文章部分内容可能需要重新着墨,请您谅解。Contact

原

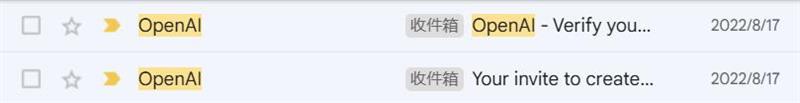

今天整理邮箱,发现了两年前我第一次注册GPT时的邮件,回望过去,这确实是值得保留的有历史意义的物件了。

犹记得当时第一次了解到ChatGPT的时候还是我在外网Discord论坛上冲浪的时候,有人提了一句ChatGPT, 还发了一条邀请链接,至此AI世界的大门向我敞开。当时GPT还只有3.5版本,还不算太聪明,但已经深深震撼到了当时的我。不久后,谷歌也不落于人后,发布了自家的Bard,再加上之后陆续发布的Palm2, Marketsuite等一系列模型,但模型的表现效果属实一般。直到后来Bard系列进化到Gemini双子星系列,才渐渐打响了名气,当时Gemini发布最大的亮点无疑是谷歌宣传片中的Gemini所展现出的“Multimodal”多模态。可惜是宣传片是精心修饰过的,后来被实锤视频造假。不过发展到现在,Gemini系列的口碑在论坛里也还算良好,毕竟谷歌挺大方,而且最近的Gemini1114和1121确实算得上出彩的模型(主要是翻译)。

再回到GPT刚发布没多久那段时间,GPT发布几个月后,因为理念不合,部分OpenAI的员工离职后创立了Anthropic,当时只有Claude Instant模型,并不聪明但唯一的好处就是可以集成到Slack上使用,而且使用时不需要科学上网,所以当时我给外院的部分人申请了一下(毕竟申请流程确实麻烦,要不是摸索两天我也会晕头转向)。再到后来POE、ANAKIN这些大模型集成平台出世,而且因为新的体系刚刚建立,诸多制度和管理确实混乱。当时POE平台的IOS端支付系统基本上是形同虚设,在那段GPT4.0最聪明的黄金时期我利用POE的漏洞搞了四个月无限制的GPT4, 属实好好过了一把AI瘾。不过后来POE支付系统完善,我也早已转战API并且通过API实现了全模型的AI自由。

接着从Claude说吧,相信用过Claude的人都百分百体验过封号之苦,我自己被封掉的号都有二十多个了,后来觉得这样折腾实在太累,索性转战API,通过API间接实现Claude自由。至于为什么那么喜欢封号,论坛里也有过讨论,最后大家一致认为的观点就是:Anthropic本质上是一个AI发展实验室,它只需要研究如何让AI变得更聪明,开发出真正的AGI。和OpenAI的商业化本质不一样,Anthropic公司赚钱基本上完全依赖于投资,所以用户体验、营收什么的根本不是它要考虑 。不管怎么说,Claude系列的模型写写文章、代码或者搞破限确实好用,Claude模型早已经成为AI生态里不可或缺的一环,大家骂归骂,该用还得用。这里放一个有关Claude的讽刺图片:

再来说一说国内的AI模型吧,目前我用过、评价还不错的有:KIMI, 智谱清言,Qwen,Deepseek和Yi-ligntning系列,各有所长,KIMI主打的是免费和长文章生成,质谱主打计算、逻辑推理等,Qwen主要还是因为开源且便宜量大,DS则是编程,YI则主要是中文语料。哦,对了,国内AI有一点确实不行,即喜欢冲榜,前段时间又发布了一个所谓的Step2模型,在榜单上排全球第二,国内第一,实测后连个简单的逻辑陷阱都分辨不出来,很明显是特意针对排行榜评价指标做了特定预设,比如IF Average (指令遵循平均):衡量模型遵循用户指令的能力,例如根据指令生成特定格式的文本、完成特定任务等。所以对于国内的AI我们总是调侃:面向benchmark训练(笑死)

现在我基本上已经在AI的使用上走到尽头了,等我下学期有时间了搞一下API中转站、镜像站和轮询,再把各种调用方式和格式梳理梳理,作为一个不深入研究机器学习的非科研人员,这样就算毕业了,毕竟属实不缺AI了,有新模型基本上也能第一时间用上,就消停消停准备毕业了。

续:2025.2.15

最近把API中转,API Proxy和各种调用方式都学完并归档了,又学习了一下Ollama本地部署LLM和工作流。说实话,本地部署LLM用途确实没有那么大,目前我发现的唯一用途便是在GPU算力平台租赁GPU,部署、拉取好模型后再穿透到公网,然后整合到视频翻译中,效果还不错,至少显著降低了视频批量翻译的成本。

另外现阶段LLM里最能打的有:o1, gemini exp 1206, Claude 3.5 sonnet和Deepseek reasoner